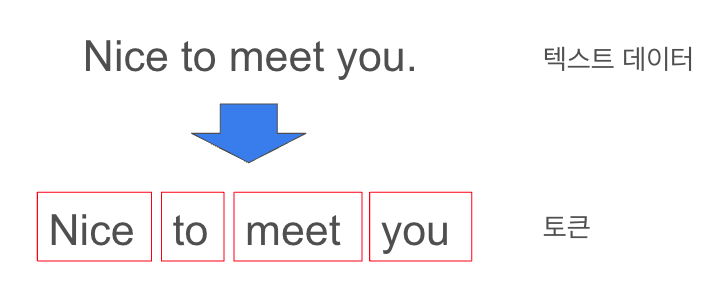

1. 데이터 로드1.1 토크나이저 로드from transformers import BertTokenizerdef get_tokenizer(): tokenizer_name = "bert-base-multilingual-cased" tokenizer = BertTokenizer.form_pretrained(tokenizer_name) return tokenizer1.2 문자열 데이터를 토큰화 하는 함수와 토큰을 자연어로 바꾸는 두개의 함수 만들기import torchdef collate_fn(batch): ''' 자연어 데이터 토큰화 적용 함수 ''' tokenizer = get_tokenizer() # 각 문장 쌍을 토크나이징하고 토큰 ID로 변환 en_ba..